Este artículo aparece en la revista Bitcoin. “La cuestión de la inscripción”. hacer clic aquí para obtener su suscripción anual a la revista Bitcoin.

hacer clic aquí para descargar un PDF de este artículo.

El valor de los bits

Los datos son el mercado de productos básicos más líquidos del mundo. En la era de los teléfonos inteligentes, a menos que se tomen precauciones extremas, donde quiera que vaya, todo lo que diga y todo lo que consume es cuantificable dentro del espectro infinito de los mercados de bienes de información. Los bienes de información, al ser bits de datos inherentemente no físicos, pueden conceptualizarse, elaborarse, producirse, fabricarse, difundirse y consumirse exclusivamente como entidades digitales. Internet, junto con otras tecnologías digitales para la computación y la comunicación, sirve como una infraestructura integral de comercio electrónico, facilitando todo el ciclo de vida de diseño, producción, distribución y consumo de una amplia gama de bienes de información. La transición fluida de los bienes de información existentes de formatos tradicionales a formatos digitales es fácilmente alcanzable, sin mencionar la colección de formatos de medios completamente inviables en el mundo analógico.

Un examen preliminar de los productos dentro de la industria de bienes de información revela que, si bien todos existen como productos de información pura y se ven afectados uniformemente por los avances tecnológicos, sus respectivos mercados experimentan distintos procesos de transformación económica. Estas variaciones en la evolución del mercado están inherentemente ligadas a diferencias en las características de los productos, métodos de producción, canales de distribución y patrones de consumo. En particular, la separación de los procesos de creación de valor y de ingresos introduce escenarios oportunistas, que potencialmente dejan a los actores establecidos del mercado con bases de clientes no rentables y procesos de creación de valor costosos pero decrecientes.

Al mismo tiempo, pueden surgir nuevas arquitecturas organizativas en respuesta a la evolución de las condiciones tecnológicas, creando y destruyendo de la noche a la mañana mercados tradicionales de bienes de información. Las cadenas de valor, originalmente concebidas bajo los supuestos de la economía tradicional de bienes de información, experimentan rediseños radicales a medida que se materializan nuevas estrategias y herramientas en respuesta a la influencia transformadora de la producción, distribución y consumo digitales sobre las propuestas de valor. datos convencionales. Por ejemplo, la vigilancia masiva nunca fue práctica cuando crear incluso una sola fotografía implicaba horas de trabajo dentro de una sala de revelación fotográfica especializada con condiciones químicas y de iluminación específicas. Ahora que hay una cámara en cada esquina, un micrófono en cada bolsillo, una entrada en el libro mayor para cada transacción financiera y los medios para transmitir dichos datos esencialmente de forma gratuita a todo el planeta, las condiciones del mercado para la vigilancia masiva han dado lugar, como era de esperar, a la vigilancia masiva. Vigilancia como servicio.

Ha crecido una industria completamente nueva de “empresas de localización”, con El marcado habiendo demarcado casi 50 empresas que venden datos de ubicación como servicio en un artículo de 2021 titulado “Existe un mercado multimillonario para los datos de ubicación de su teléfono” de Keegan y Ng. Una de esas empresas, Near, se describe a sí misma como curadora de “una de las mayores fuentes de inteligencia del mundo sobre personas y lugares”, habiendo recopilado datos que representan a casi dos mil millones de personas en 44 países. De acuerdo a la ONU Investigación de gran vista En el informe titulado “Informe de participación y tamaño del mercado de inteligencia de ubicación, 2030”, la capitalización del mercado global de datos de inteligencia de ubicación tenía un valor estimado de “$ 16,09 mil millones en 2022 y se proyecta que crecerá a una tasa de crecimiento anual compuesta (CAGR) del 15,6% de 2023 a 2030”. La capitalización de mercado de esta nueva industria de bienes de información está impulsada principalmente por la creciente penetración de dispositivos inteligentes y las crecientes inversiones en IoT. [internet of things] y servicios de red, ya que facilita aplicaciones más inteligentes y una mejor conectividad de red”, dando crédito a la idea de que el avance tecnológico lidera el crecimiento de la red, que a su vez lidera formas completamente nuevas de mercados de comercio electrónico. Esto, por supuesto, se vio acelerado por la pandemia de COVID-19, en la que las políticas gubernamentales dieron como resultado “la mayor adopción de soluciones de inteligencia de ubicación para gestionar el cambiante escenario empresarial, ya que ayuda a las empresas a analizar , mapear y compartir datos en términos de ubicación de sus clientes”, bajo la apariencia de salud del usuario y de la sociedad.

Dentro de cualquier mercado de bienes de información, sólo hay dos resultados posibles para los participantes del mercado: distribuir los datos adquiridos o conservarlos para usted.

El mercado moderno de bienes de información.

En el otoño de 2021, China lanzó el Shanghai Data Exchange (SDE) en un intento de crear un monopolio estatal en un novedoso mercado especulativo de productos básicos para datos extraídos de una de las poblaciones más vigiladas digitalmente del planeta. La SDE ofreció 20 productos de datos en el lanzamiento, incluida información de vuelos de clientes de China Eastern Airlines, así como datos de operadores de redes de telecomunicaciones como China Unicom, China Telecom y China Mobile. En particular, una de las primeras transacciones conocidas realizadas en la SDE fue la compra de datos por parte del Banco Comercial de China de la Compañía Estatal de Energía Eléctrica Municipal de Shanghai con el pretexto de mejorar sus servicios financieros y su oferta de productos.

Poco antes de la fundación de este intercambio de datos, se citó a Huang Qifan, ex alcalde de Chongqing, diciendo que “el Estado debería monopolizar los derechos para regular los datos y ejecutar los intercambios de datos”, al tiempo que sugeriría que el PCC Debería ser muy selectivo a la hora de establecer intensificar los intercambios de datos. «Al igual que las bolsas de valores, Beijing, Shanghai y Shenzhen pueden tener una, pero una capital provincial general o una ciudad municipal no deberían tenerla».

Si bien el actual mercado de bienes de información ha dado lugar a innovaciones como la especulación sobre la compra de grandes cantidades de datos de usuario, el mercado de datos moderno comenzó en serio a finales de la década de 1970, como lo ejemplificó la formación de Oracle Corporation en 1977, que lleva el nombre del “Proyecto Oracle” de la CIA, que contó con los eventuales cofundadores de Oracle Corporation, Larry Ellison, Robert Miner y Ed Oates. La CIA fue su primer cliente y, en 2002, contratos por valor de casi 2.500 millones de dólares provinieron de la venta de software a gobiernos federales, estatales y locales, lo que representó casi una cuarta parte de sus ingresos totales. Sólo unos meses después del 11 de septiembre de 2001, Ellison escribió un artículo de opinión para el New York Times titulado “Una única base de datos de seguridad nacional” en el que el párrafo inicial dice “El mayor paso que nosotros, los estadounidenses, podríamos dar para hacer la vida más difícil a los terroristas sería garantizar que toda la información contenida en innumerables bases de Los datos gubernamentales se copiarán en una base de datos de seguridad nacional única e integral”. base de datos». Ellison fue citado en el libro de Jeffrey Rosen. La multitud desnuda como dice “La base de datos Oracle se utiliza para realizar un seguimiento de básicamente todo. La información sobre sus bancos, su saldo corriente, su saldo de ahorro, se almacena en una base de datos Oracle. Su reserva de aerolínea se almacena en una base de datos de Oracle. Los libros que compraste en Amazon se almacenan en una base de datos de Oracle. Tu perfil en Yahoo! se almacena en una base de datos Oracle”. Rosen tomó nota de una conversación con David Carney, un ex empleado de los tres primeros puestos de la CIA, quien, después de 32 años de servicio en la agencia, fue para unirse a Oracle sólo dos meses después del 11 de septiembre para dirigir su Centro de Garantía de Información:

«¿Cómo dices esto sin parecer insensible?» [Carney] preguntó. «De cierto modo, el 11 de septiembre facilitó un poco los negocios. Antes del 11 de septiembre prácticamente había que exagerar la amenaza y el problema». Carney dijo que el verano anterior a los ataques, los líderes de los sectores público y privado no se quedaron tranquilos para recibir información. Entonces su rostro se iluminó. «¡Ahora lo piden a gritos!»

Esta relación ha continuado durante 20 años y, en noviembre de 2022, la CIA otorgó su contrato Commercial Cloud Enterprise a cinco empresas estadounidenses: Amazon Web Services, Microsoft, Google, IBM y Oracle. Si bien la CIA no reveló el valor exacto del contrato, los documentos publicados en 2019 sugirieron que podrían ascender a “decenas de millas de millones” de dólares en los próximos 15 años. Desafortunadamente, esta está lejos de ser la única integración del mercado de datos del sector privado, las agencias gubernamentales y la comunidad de inteligencia, tal vez mejor ejemplificada por el corredor de datos LexisNexis.

LexisNexis se fundó en 1970 y, desde 2006, es la base de datos electrónicos más grande del mundo para información legal y relacionada con registros públicos. Según su propio sitio web, LexisNexis se describe a sí mismo como proveedor de «un conjunto integral de soluciones para dotar a las agencias gubernamentales de datos, tecnología y análisis superiores para respaldar el éxito de la misión». LexisNexis está formada por nueve miembros de la junta directiva: el director ejecutivo Haywood Talcove; el Dr. Richard Tubb, el médico de la Casa Blanca con más años de servicio en la historia de Estados Unidos; Stacia Hylton, ex subdirectora del Servicio de Mariscal de Estados Unidos; Brian Stafford, exdirector del Servicio Secreto de Estados Unidos; Lee Rivas, director ejecutivo del sector público y de las unidades de negocios de atención médica de LexisNexis Risk Solutions; Howard Safir, ex comisionado de la policía de Nueva York y director asociado de operaciones del Servicio de Alguaciles de Estados Unidos; Floyd Clarke, exdirector del FBI; Henry Udow, director jurídico y secretario de la empresa RELX Group; y por último Alan Wade, director de información retirado de la CIA.

Mientras Wade todavía era empleado de la CIA, fundó Chiliad con Christine Maxwell, hermana de Ghislaine Maxwell e hija de Robert Maxwell. Christine Maxwell es considerada «una de las primeras pioneras de Internet», ya que fundó Magellan en 1993, uno de los principales motores de búsqueda de Internet. Después de vender Magellan a Excite, reinvirtió su importante ganancia inesperada en otra empresa de tecnología de búsqueda de big data: la antes mencionada Chiliad. Según un informe de 2020 de OYE.NEWS, Chiliad hizo uso de «minería inteligente, masivamente escalable y bajo demanda de datos estructurados y no estructurados mediante el uso de tecnologías de búsqueda de lenguaje natural», con el software propietario de la empresa «detrás de la búsqueda de datos». tecnología utilizada por el almacén de datos antiterroristas del FBI”.

En noviembre de 2023, LexisNexis, conectada a Wade, recibió un contrato de cinco años y 16 millones de dólares con la Oficina de Aduanas y Protección Fronteriza de EE. UU. UU. “para acceder a un potente conjunto de herramientas de vigilancia”, según los registros públicos disponibles, que proporciona acceso a “monitoreo de redes sociales, datos web como direcciones de correo electrónico y ubicaciones de direcciones IP, datos de reserva de cárcel en tiempo real , servicios de reconocimiento facial y herramientas de análisis de datos de geolocalización de teléfonos móviles”. Desafortunadamente, esta está lejos de ser la única agencia gubernamental que utiliza la intermediación de datos de LexisNexis con el objetivo. de eludir el derecho constitucional y las libertades civiles en lo que respeta a la vigilancia.

En el otoño de 2020, LexisNexis se vio obligada a llegar a un acuerdo por más de 5 millones de dólares después de que una demanda colectiva alegara que el corredor vendió datos del Departamento de Vehículos Motorizados a bufetes de abogados estadounidenses, que luego fueron libres de utilizarlos para sus propios fines comerciales. «Los sitios web de los demandados permiten la compra de informes de accidentes por fecha del informe, ubicación o nombre del conductor y el pago con tarjeta de crédito, cuentas prepagas al por mayor o cuentas mensuales», se lee en la demanda. «Los compradores no están obligados a establecer ningún uso permisible previsto en la DPPA para obtener acceso a los MVR de los demandantes y miembros del grupo”. En el verano de 2022, una solicitud de la Ley de Libertad de Información reveló un contrato de 22 millones de dólares entre el Servicio de Inmigración y Control de Aduanas y LexisNexis. Sejal Zota, director de Just Futures Law y abogado en ejercicio que trabaja en la demanda, señaló que LexisNexis hace posible que ICE «acceda instantáneamente a datos personales confidenciales, todo sin órdenes judiciales, citaciones, salvaguardias de privacidad ni ninguna muestra de razonabilidad».

En la denuncia antes mencionada de 2022, el uso del producto Accurint de LexisNexis permite a «los agentes del orden [to] vigilar y rastrear a las personas basándose en información que estos agentes, en muchos casos, no podrían obtener sin una citación, orden judicial u otro proceso legal… permitiendo un estado de vigilancia masiva con archivos de casi todos los consumidores adultos estadounidenses”.

Una serie de tubos

En 2013, llamó la atención del público que la Agencia de Seguridad Nacional había violado encubiertamente los principales enlaces de comunicación que conectaban los centros de datos de Yahoo y Google en todo el mundo. Esta información se basó en documentos p Publicado por WikiLeaks, obtenida originalmente del excontratista de la NSA Edward Snowden, y corroborado por entrevistas a funcionarios del gobierno.

Según un informe clasificado del 9 de enero de 2013, la NSA transmite millones de registros diariamente desde las redes internas de Yahoo y Google a depósitos de datos en la sede de la agencia en Fort Meade, Maryland. En el mes anterior, los recolectores de campo procesaron y devolvieron 181.280.466 nuevos registros, que incluyen «metadatos» que revelan detalles sobre los remitentes y destinatarios de los correos electrónicos, junto con marcas de tiempo, así como el contenido real, incluidos datos. de texto, audio y vídeo.

La principal herramienta empleada por la NSA para explotar estos enlaces de datos es un proyecto llamado MUSCULAR, llevado a cabo en colaboración con la Sede de Comunicaciones del Gobierno Británico (GCHQ). Operando desde puntos de interceptación no revelados, la NSA y el GCHQ copian flujos de datos completos a través de cables de fibra óptica que conectan los centros de datos de las principales corporaciones de Silicon Valley.

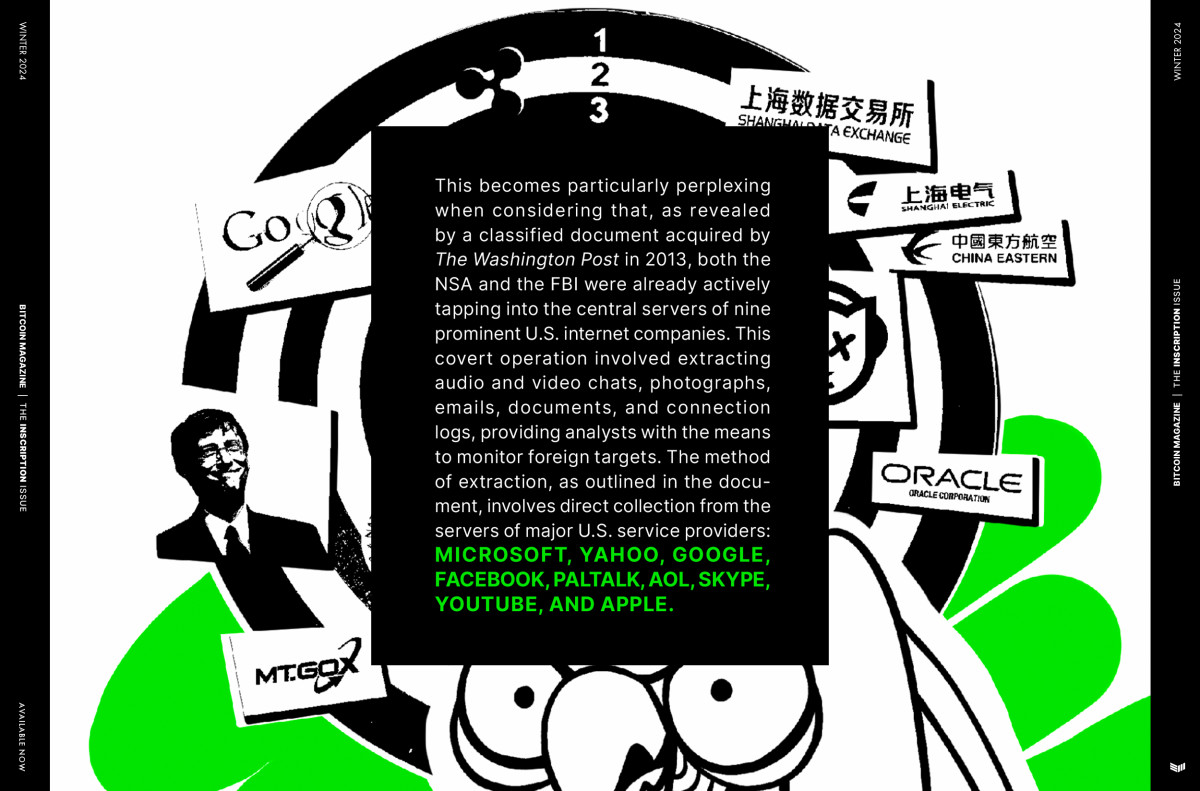

Esto resulta particularmente desconcertante si se considera que, como revela un documento clasificado adquirido por El Correo de Washington En 2013, tanto la NSA como el FBI ya estaban accediendo activamente a los servidores centrales de nueve destacadas empresas de Internet estadounidenses. Esta operación encubierta implicó la extracción de chats de audio y video, fotografías, correos electrónicos, documentos y registros de conexión, proporcionando a los analistas los medios para monitorear objetivos extranjeros. El método de extracción, como se describe en el documento, implica la recolección directa de los servidores de los principales proveedores de servicios de EE. UU. UU.: Microsoft, Yahoo, Google, Facebook, PalTalk, AOL, Skype, YouTube y Apple.

Durante el mismo período, el periódico el guardián informó que el GCHQ (la contraparte británica de la NSA) estaba recopilando clandestinamente inteligencia de estas empresas de Internet a través de un esfuerzo de colaboración con la NSA. Según documentos obtenidos por el guardiánel programa PRISM aparentemente permite al GCHQ eludir los procedimientos legales formales requeridos en Gran Bretaña para solicitar materiales personales, como correos electrónicos, fotografías y vídeos, de empresas de Internet con sede fuera del país.

PRISM surgió en 2007 como sucesor del programa secreto de vigilancia interna sin orden judicial del presidente George W. Bush, tras revelaciones de los medios de comunicación, demandas e intervenciones del Tribunal de Vigilancia de Inteligencia Extranjera. El Congreso respondió con la Ley de Protección de Estados Unidos de 2007 y la Ley de Enmiendas FISA de 2008, que otorgan inmunidad legal a las empresas privadas que cooperan voluntariamente con la recopilación de inteligencia estadounidense. Microsoft se convirtió en el socio inaugural de PRISM, lo que marcó el comienzo de años de extensa recopilación de datos bajo la superficie de un acalorado discurso nacional sobre vigilancia y privacidad.

En una declaración de junio de 2013, el entonces Director de Inteligencia Nacional James R. Clapper dijo que “la información recopilada bajo este programa se encuentra entre la información de inteligencia extranjera más importante y valiosa que recopilamos y se utiliza para proteger a nuestra nación de una amplia variedad de amenazas. La divulgación no autorizada de información sobre este importante programa totalmente legal es reprobable y pone en riesgo importantes protecciones para la seguridad de los estadounidenses”.

¿Por qué entonces la necesidad de recolectar directamente de los cables de fibra óptica si estas empresas privadas? ellos mismos ¿Ya están proporcionando datos a la comunidad de inteligencia nacional? Tras una mayor investigación sobre los intermediarios de datos de la NSA y la CIA antes mencionados, parecería que una gran mayoría de los nuevos cables submarinos de fibra óptica (infraestructura esencial para la actualización de Internet como mercado global de datos) están siendo construidos por estos mismas compañías privadas. Estos discretos cables recoren el fondo del océano global y transportan entre el 95% y el 99% de los datos internacionales a través de haces de hilos de fibra óptica apenas más horribles que una manguera de jardín estándar. En total, la red activa comprende más de 1.100.000 kilómetros de cables submarinos.

Tradicionalmente, estos cables han sido propiedad de un consorcio de empresas privadas, principalmente proveedores de telecomunicaciones. Sin embargo, ha surgido un cambio notable. En 2016, comenzó un aumento significativo en el desarrollo de cables submarinos y, en particular, esta vez, los compradores son proveedores de contenido, en particular los corredores de datos Meta/Facebook, Google, Microsoft y Amazon. Destaca Google, que ha adquirido más de 100.000 kilómetros de cables submarinos. Con la finalización del Cable Curie en 2019, la propiedad de Google sobre cables submarinos a nivel mundial asciende al 1,4%, medida por longitud. Si se tienen en cuenta los cables de propiedad compartida, la cuota total de Google aumenta hasta aproximadamente el 8,5%. Facebook le sigue poco después con 92.000 kilómetros, Amazon con 30.000 y Microsoft con unos 6.500 kilómetros del cable MAREA, de propiedad parcial.

Hay una reactivación notable en el sector del cable submarino, impulsada principalmente por las inversiones de Facebook y Google, que representan alrededor del 80% de las inversiones en conexiones transatlánticas entre 2018 y 2020, un aumento significativo con respecto al menos del 20% que representaron en los tres anteriores. años hasta 2017, según lo informado por TeleGeography. Esta ola de gigantes digitales ha transformado principalmente la dinámica de la industria. A diferencia de las prácticas tradicionales en las que las compañías telefónicas establecían empresas dedicadas a la construcción de cables, que a menudo conectaban Inglaterra con Estados Unidos para llamadas de voz y tráfico de datos limitado, estas empresas de Internet ahora ejercen una influencia considerable. Pueden dictar las ubicaciones de los cables, colocándolos estratégicamente cerca de sus centros de datos, y tener la flexibilidad de modificar las estructuras de las líneas (que normalmente cuestan alrededor de 200 millones de dólares para un enlace transatlántico) sin esperar la aprobación de los socios. . Estos gigantes tecnológicos pretenden capitalizar la creciente demanda de transferencias rápidas de datos esenciales para diversas aplicaciones, incluida la transmisión de películas, la mensajería social e incluso la telemedicina.

La última vez que vimos tal explosión de actividad en la construcción de infraestructura esencial de Internet fue durante el auge de las puntocom de la década de 1990, en el que las compañías telefónicas gastaron más de 20 mil millones de dólares para instalar líneas de fibra. bajo los océanos, inmediatamente antes de la proliferación masiva. de computadoras personales, módems de Internet domésticos y redes de datos de igual a igual.

lavado de datos

El nacimiento de nuevas tecnologías de compresión en forma de formatos de medios digitales en sí no habría dado lugar al panóptico en el que operamos actualmente sin la capacidad de ofuscar la carga y descarga masiva de estos datos recién creados a través de los rieles de los ISP. tanto del sector público como del privado. empresas de infraestructura. Probablemente no sea casualidad que la creación de estas herramientas, redes y algoritmos se creara bajo la influencia de agencias de inteligencia nacionales justo antes del cambio de milenio, el auge de Internet de banda ancha y el amplio espionaje inconstitucional a los ciudadanos legalizados a través de la Ley Patriota tras los acontecimientos del 11 de septiembre de 2001.

Con solo 15 años, Sean Parker, eventual fundador de Napster y primer presidente de Facebook (un antiguo proyecto de DARPA titulado LifeLog) llamó la atención del FBI por sus hazañas de piratería informática, que terminaron en un servicio comunitario designado por el estado. Un año más tarde, Parker fue reclutado por la CIA después de ganar una feria de informática del estado de Virginia al desarrollar una de las primeras aplicaciones de rastreo de Internet. En lugar de continuar sus estudios, hizo una pasantía en una startup de DC, FreeLoader y, finalmente, en UUNet, un proveedor de servicios de Internet. «No iba a la escuela», dijo Parker. Forbes. «Técnicamente estaba en un programa cooperativo, pero en realidad iba a funcionar». Parker ganó casi seis cifras en su último año de secundaria y finalmente fundó el sitio para compartir música entre pares que se convirtió en Napster en 1999. Mientras trabajaba en Napster, Parker conoció al inversionista Ron Conway, quien ha respaldado todos los productos de Parker desde entonces, habiendo También respaldó anteriormente a PayPal, Google y Twitter, entre otros. Napster ha sido reconocida como una de las empresas de más rápido crecimiento de todos los tiempos, y no se puede subestimar su influencia en los mercados de bienes de información y datos en la era de Internet.

En un estudio realizado entre abril de 2000 y noviembre de 2001 por Sandvine titulado “Compartición de archivos entre pares: el impacto del intercambio de archivos en las redes de proveedores de servicios”, las mediciones de red revelaron un cambio notable en los patrones de consumo. de ancho de banda debido al lanzamiento de nuevas redes de pares. herramientas -to-peer, así como nuevos algoritmos de compresión como .MP3. Específicamente, el porcentaje de ancho de banda de la red atribuido al tráfico de Napster experimentó un aumento del 23% al 30%, mientras que el tráfico relacionado con la web experimentó una ligera disminución del 20% al 19%. En 2002, las observaciones indicaron que el tráfico de intercambio de archivos consumía una porción sustancial, hasta el 60%, del ancho de banda de los proveedores de servicios de Internet. La creación de nuevos mercados de bienes de información es consecuencia de nuevas capacidades tecnológicas, con implicaciones en el alcance y la escalada de la actual proliferación del flujo de datos, claramente perceptibles en el dominio de la actividad de los usuarios de Internet pertenecientes a las comunicaciones. en rojo entre pares.

Por supuesto, la tecnología peer-to-peer no dejó de avanzar después de Napster, y la invención de los «enjambres», un estilo de descarga y carga esencial para el desarrollo de BitTorrent de Bram Cohen, fue inventado para eDonkey2000 por Jed McCaleb, el eventual fundador de Mt.Gox, Ripple. Labs y la Fundación Stellar. La proliferación del intercambio avanzado de paquetes a través de Internet ha dado lugar a tipos completamente nuevos de mercados de bienes de información, que esencialmente se reducen a tres axiomas principales; datos públicos y permanentes, datos selectivamente privados y datos codiciados pero difíciles de obtener.

Mercados de datos nativos de Bitcoin

Inscripciones recursivas padre/hijo

Si bien publicar directamente en Bitcoin no es un fenómeno nuevo, la popularización de Ord, lanzada por el desarrollador de Bitcoin Casey Rodarmor en 2022, ha provocado un aumento masivo del interés y la actividad en las publicaciones nativas de Bitcoin. Si bien ciertamente parte de esto puede atribuirse a una cultura artística recién formada que desvía actividad y valor de Ethereum (y otras empresas alternativas que hacen afirmaciones erróneas de publicación nativa de blockchain), la mayor parte de este volumen proviene de la construcción de estas transacciones. de inscripción que utiliza el descuento de SegWit a través del script Taproot especialmente creado y el conocimiento de la inmutabilidad, durabilidad y disponibilidad de los datos que ofrece únicamente la cadena de bloques de Bitcoin. El descuento SegWit se creó específicamente para incentivar la consolidación de resultados de transacciones no gastadas y limitar la creación de cambios excesivos en el conjunto UTXO, pero en cuanto a sus implicaciones en la publicación nativa de Bitcoin, esencialmente ha creado una rebaja sustancial del 75%. en el costo de bits dentro de un bloque que están llenos de datos arbitrarios dentro de una inscripción. Esto está lejos de ser un factor irrelevante en la creación de un mercado de bienes de información sostenible.

Llevando esto un paso más allá, la implementación de un mecanismo de inscripción autorreferencial permite a los usuarios encadenar la publicación de datos en Múltiples bloques de Bitcoin, limitando los costos de incluir un archivo en una subasta de un solo bloque. Esto implica tanto la capacidad de inscribir archivos de más de 4 MB como la utilidad para hacer referencia a material previamente inscrito, como software ejecutable, código de arte generativo o los propios recursos de imagen. En el caso del reciente Proyecto Spartacus, se utilizaron inscripciones recursivas que utilizan lo que se conoce como inscripción principal para permitir esencialmente un mecanismo de financiación colectiva con el fin de obtener públicamente los satoshis necesarios para publicar los registros de la guerra afgana en la cadena de bloques de Bitcoin para siempre. Esto resuelve la necesidad de publicación pública y permanente de datos conocidos y disponibles por parte de un conjunto de usuarios seudónimos, pero requiere cierta disponibilidad de datos durante el proceso de acuñación en sí, lo que abre la puerta a puntos de presión centralizados ya una posible censura de las transacciones de inscripción dentro de un sistema público. menta por grupos mineros nefastos.

Inscripciones Precursivas

Con la llegada de las inscripciones nativas de Bitcoin, la posibilidad de una publicación inmutable, duradera y con censura reducida se ha hecho realidad. La versión actual de la tecnología de inscripción permite a los usuarios publicar sus datos a través de una transacción de Bitcoin permanente pero propagada públicamente. Sin embargo, esta realidad ha provocado que las transacciones de inscripción aún por confirmar y sus datos asociados sean notados mientras está dentro del propio mempool. Este problema se puede mitigar introduciendo cifrado dentro del proceso de inscripción, dejando datos cifrados pero inofensivos para que los nodos de Bitcoin los propaguen y, finalmente, los mineros de Bitcoin los publiquen, pero sin posibilidad de ser censurados debido al contenido. Esto también elimina la posibilidad de que las inscripciones destinadas a la especulación sean adelantadas por recolectores maliciosos que extraen datos de inscripción del mempool y los retransmiten a una tarifa mayor para poder confirmarlos antes.

Las inscripciones precursivas tienen como objetivo crear la publicación privada y cifrada de datos distribuidos en Múltiples bloques de Bitcoin que pueden publicarse a voluntad mediante una transacción de publicación recursiva que contiene la clave privada para descifrar los datos previamente inscritos. Por ejemplo, un colectivo de denunciantes podría subir datos discretamente a la cadena de bloques de Bitcoin, sin que los mineros o los corredores de nodos lo sepan, y posponer su publicación hasta el momento preferido. Dado que los datos se cifrarán durante su fase de inscripción inicial, y dado que los datos aparentemente no estarán correlacionados hasta que la transacción de publicación los asociados de forma recursiva, un usuario puede renunciar y propagar continuamente la inscripción principal bloqueada en el tiempo durante periodos. de tiempo prolongados. Si el usuario no puede firmar otra transacción de publicación con bloqueo de tiempo debido a su encarcelamiento, la transacción de publicación propagada se confirmará después de que finalice el período de bloqueo de tiempo, lo que le dará al editor un mecanismo de cambio de hombre muerto. .

El proceso de inscripción precursiva especialmente diseñado y presentado en este artículo ofrece un enfoque novedoso para la publicación de datos segura y resistente a la censura dentro de la cadena de bloques de Bitcoin. Al aprovechar las características inherentes de la red Bitcoin, como su naturaleza descentralizada e inmutable, el método aquí descrito aborda varios desafíos clave en el campo de los bienes de información, la inscripción y la difusión de datos. El objetivo principal de las inscripciones precursivas es mejorar la seguridad y privacidad de los datos almacenados en la cadena de bloques de Bitcoin, al tiempo que mitiga el riesgo de divulgación prematura. Una de las ventajas más importantes de este enfoque es su capacidad para garantizar que el contenido permanezca oculto hasta que el usuario decida revelarlo. Este proceso no sólo proporciona seguridad a los datos, sino que también mantiene la integridad y permanencia de los datos dentro de la cadena de bloques de Bitcoin.

Esto nos lleva a la tercera y última bifurcación de los buenos mercados de datos de información necesaria para la era moderna; Fije el precio de los bits deseados pero actualmente no obtenidos.

pedido

ReQuest tiene como objetivo crear un mercado de datos novedoso que permita a los usuarios otorgar recompensas por datos codiciados, buscando el almacenamiento seguro e inmutable de información específica en la cadena de bloques de Bitcoin. La recompensa principal cumple una doble función al cubrir los costos de publicación y recompensar a quienes cumplen con éxito la solicitud. Además, el protocolo permite aumentar las recompensas a través de contribuciones de otros usuarios, aumentando las posibilidades de cumplimiento exitoso. Después del envío de una inscripción, los usuarios que iniciaron la recompensa pueden participar en un proceso de validación social para verificar la exactitud de los datos inscritos.

La implementación de este concepto implica una combinación de investigación social para garantizar la precisión de los datos, evaluar las contribuciones a la recompensa y adherirse a parámetros contractuales específicos medidos en tamaño de bytes. El proceso de cumplimiento de recompensas requiere que los cumplidores elegibles envíen su hash de transacción de inscripción o un enlace magnético en vivo para su consideración. En los casos en los que los datos deseados están disponibles pero no están publicados de forma nativa en Bitcoin (o son ampliamente conocidos pero actualmente no están disponibles, como un archivo .STL de renombre o una actualización de software de cliente), el protocolo ofrece un método alternativo al consenso social para su cumplimiento, que implica el hash de los datos. archivo y verificar la salida SHA-256 resultante, que proporciona un medio infalible para cumplir con los requisitos de la recompensa. La naturaleza colaborativa de estas recompensas, junto con su capacidad para abarcar varios tipos de datos, garantiza que el modelo de ReQuest pueda abordar de manera efectiva un amplio espectro de necesidades de información en el mercado.

Para las recompensas de ReQuest que implican archivos de gran tamaño que no son adecuados para la inscripción directa en la cadena de bloques de Bitcoin, se ha propuesto una arquitectura alternativa conocida como Durabit, en la que se inscribe un enlace magnético de BitTorrent y su siembra. se mantiene a través de una estructura de incentivos con bloqueo de tiempo nativo de Bitcoin. .

Durabit

Durabit tiene como objetivo incentivar la distribución de datos grandes y duraderos en la era de la información. A través de transacciones de Bitcoin con tiempo limitado y el uso de enlaces magnéticos publicados directamente dentro de los bloques de Bitcoin, Durabit fomenta la siembra activa a largo plazo e incluso ayuda a compensar los costos operativos iniciales. A medida que aumenta la recompensa, la participación de los usuarios se vuelve cada vez más atractiva, lo que crea una estructura de incentivos autosostenibles para la distribución de contenidos. El protocolo Durabit aumenta los pagos de recompensas para proporcionar un incentivo sostenido para la siembra de datos. Esto no se hace aumentando las recompensas en términos de satoshi, sino más bien aumentando exponencialmente la duración de la época entre pagos, aprovechando el supuesto aumento de precios a largo plazo debido a la política económica deflacionaria para mantener bajos los costos de distribución iniciales. Durabit tiene el potencial de diseñar un tipo específico de mercado de bienes de información a través del intercambio de archivos monetizados e integrar aún más Bitcoin en la revolución de igual a igual que lleva décadas.

Estos nuevos mercados de bienes de información actualizados por las nuevas herramientas nativas de Bitcon pueden potencialmente replantear la lucha por publicar, encontrar y mantener datos a medida que la plaza pública continúa erosionándose.

Aumentando el costo de la conspiración

La guerra de la información se libra en dos frentes; la arquitectura que incentiva la publicación de datos públicos duraderos e inmutables, y la desincentivación de la recopilación a gran escala de datos personales, que a menudo se nos venden en forma de contenido comercial especializado o son vigilados por inteligencia para ayudar en propaganda dirigida, operaciones psicológicas y la restricción de narrativas y editores disidentes. Se presentan las comodidades que ofrecen las aplicaciones de jardín amurallado y las redes de nombre exclusivo del sector privado para acceder a una gran cantidad de metadatos de usuarios reales. Si bien las métricas de los usuarios pueden inflarse, los datos obtenidos de estos robots son completamente inútiles para la recopilación de datos de aplicaciones comerciales como los modelos de aprendizaje de idiomas (LLM) y las interfaces de IA aplicables actualmente.

Hay dos axiomas en los que estos algoritmos necesitan datos verificables; la autenticidad del código del modelo en sí y la entrada seleccionada que inevitablemente analiza. En cuanto al protocolo en sí, para garantizar la replicabilidad de las funciones deseadas y mitigar cualquier funcionalidad adversa dañina, se podrían utilizar técnicas como el hash de código previamente auditado al publicar actualizaciones de estado. Aparentemente, lidiar con los aportes del material de aprendizaje de estos LLM también tiene dos frentes; soberanía criptográfica sobre los datos que realmente son valiosos para el mercado abierto, y la interferencia activa de la fidelidad de la señal con datos basura. Quizás no sea realista esperar que una persona común API ejecute generadores de ruido que alimentan constantemente los conjuntos de datos públicos cultivados con montones de datos con pérdida, lo que genera una retroalimentación basada en datos sobre estos algoritmos de autoaprendizaje. Pero al crear estructuras de datos y mercados alternativos, construidas según las cualidades del “bien de información” específico, tal vez p odamos incentivar –al menos subsidiar– el costo económico percibido de que la gente común renuncie a sus comodidades. La tendencia a la deflación de los costos de publicación a través de medios digitales y la interconectividad de Internet ha hecho que sea aún más esencial para que la gente común recupere al menos el control de sus propios metadatos.

No son simplemente los datos el nuevo bien de la era digital, sino su datos: dónde ha estado, qué ha comprado, con quién habla y los muchos porqués manipulados que pueden triangularse a partir de los dónde, qué y quiénes antes mencionados. Al mitigar el acceso a estos datos a través de métodos de ofuscación, como el uso de VPN, realizar transacciones con herramientas de pago privadas y elegir hardware impulsado por cierto software de código abierto, los usuarios pueden aumentar significativamente el costo necesario para la recopilación de datos por parte de la comunidad de inteligencia y sus compatriotas del sector privado. . La era de la información requiere participantes comprometidos, incentivados por las estructuras que sostienen y distribuyen los datos del mundo (sus datos) en los últimos nichos que quedan de la plaza pública, así como una retención activa y alentada de nuestra propia información.

La mayoría de las veces, un número grande y aleatorio representado en bits tiene poco valor para un posible comprador. Y, sin embargo, la propiedad de reserva de valor de Bitcoin se deriva enteramente de que los usuarios pueden publicar públicamente e inmutablemente una firma en la cadena de bloques, algo que sólo es posible si se mantiene exitosamente una clave privada en secreto. El precio de una tarifa de transacción de Bitcoin de capa base no se fija en función de la cantidad de valor transferido, sino de cuántos bytes de espacio se requieren en un bloque específico para articular todas sus restricciones de gasto, representadas en sat/vbyte. Bitcoin es una base de datos que logra incentivar a los usuarios a replicar su libro de contabilidad, comunicar sus actualizaciones de estado y utilizar grandes cantidades de energía para aleatorizar su modelo de consenso.

Cada diez minutos, de media, se realiza otra subasta de 4 MB.

Si quieres que la información sea gratuita, dale libre mercado.

Este artículo aparece en la revista Bitcoin. “La cuestión de la inscripción”. hacer clic aquí para obtener su suscripción anual a la revista Bitcoin.

hacer clic aquí para descargar un PDF de este artículo.