En Northwell Health, los ejecutivos están animando a los médicos ya los 85.000 empleados a utilizar una herramienta llamada AI Hub, según una presentación obtenida por 404 Media.

Northwell Health, el proveedor de atención médica más grande del estado de Nueva York, lanzó recientemente una herramienta de modelo de lenguaje de gran tamaño que está animando a los médicos y médicos a utilizarla para traducir datos confidenciales de pacientes, y ha sugerido que se puede utilizar con fines de diagnóstico, según supo 404 Media. Northwell Health tiene más de 85.000 empleados.

Una presentación interna y chats de empleados obtenidos por 404 Media muestra cómo los profesionales de la salud utilizan LLM y chatbots para editar escritos, tomar decisiones de contratación, realizar tareas administrativas y manejar datos de pacientes.

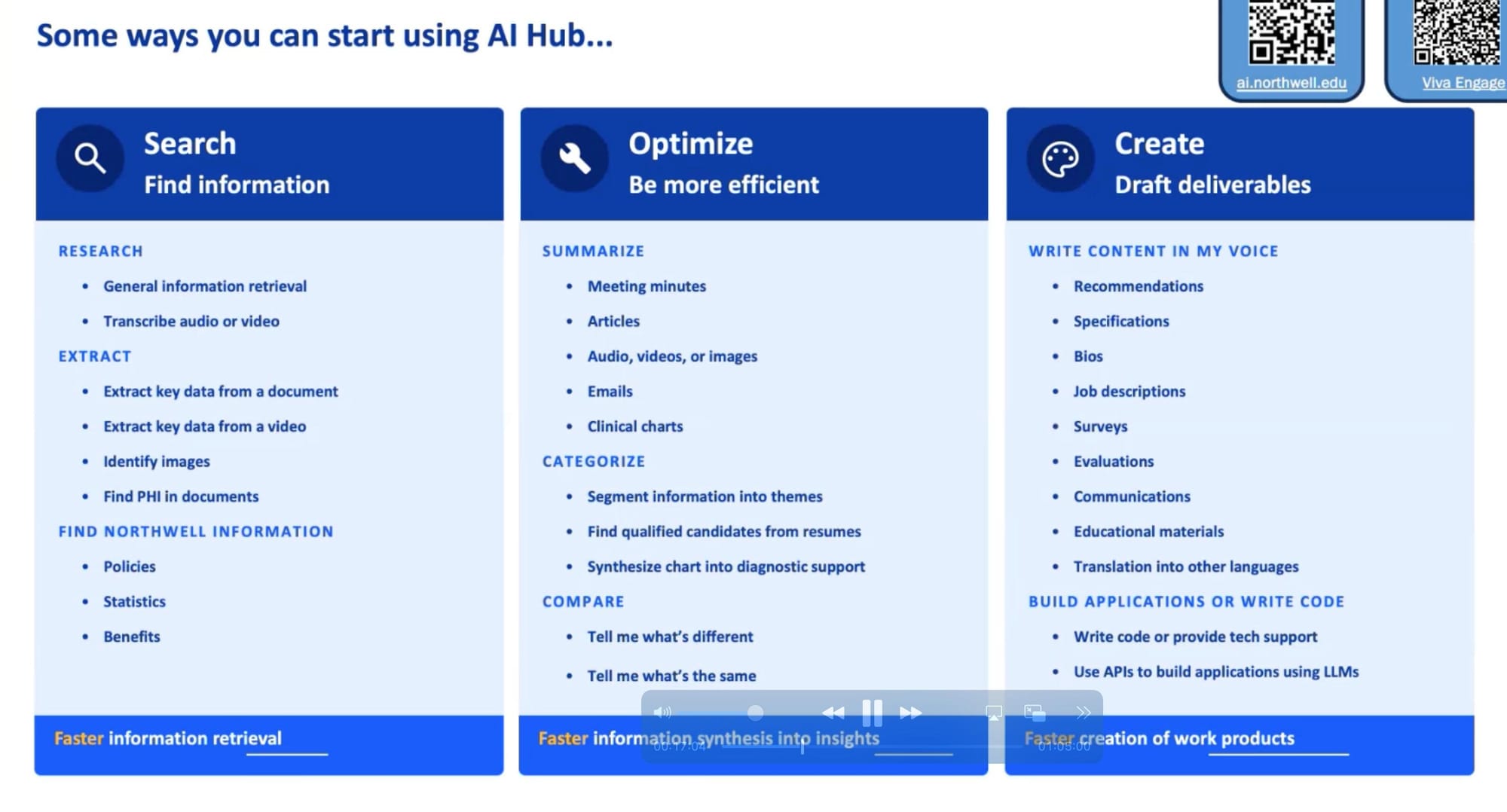

En la presentación realizada en agosto, Rebecca Kaul, vicepresidenta senior y jefa de innovación y transformación digital de Northwell, junto con un ingeniero senior, discutieron el lanzamiento de la herramienta, llamada AI Hub, y dieron una demostración de cómo los médicos e investigadores: o cualquier persona con una dirección de correo electrónico de Northwell puede utilizarla.

Centro de IA “ee.uu. [a] LLM generativo, utilizado de manera muy similar a cualquier otra plataforma interna/administrativa: Microsoft 365, etc. para tareas como mejorar correos electrónicos, revisar la gramática y la ortografía y resumir resúmenes”, dijo un portavoz de Northwell a 404 Media. “Sigue los mismos estándares federales de cumplimiento y protocolos de privacidad para las herramientas mencionadas en nuestra red cerrada. No fue diseñado para tomar decisiones médicas y no está conectado a nuestras bases de datos clínicas”.

Pero la presentación y los materiales vistos por 404 Media incluyen un liderazgo que dice que AI Hub se puede utilizar para tareas «clínicas o clínicas adyacentes», así como para responder preguntas sobre políticas y facturación del hospital, escribir descripciones de trabajo y editar escritos, y resumir extractos de registros médicos electrónicos. e ingresar información de salud protegida y de identificación personal de los pacientes. La demostración también mostró capacidades potenciales que incluían «detectar cáncer de páncreas» y «analizar HL7», un estándar de datos de salud utilizado para compartir registros médicos electrónicos.

La presentación filtrada muestra que los hospitales utilizan cada vez más la IA y los LLM para agilizar las tareas administrativas, y muestra que algunos están experimentando o al menos considerando cómo se utilizarían los LLM en entornos clínicos o en las interacciones con los pacientes.

En el foro interno de empleados de Northwell, alguien preguntó si podía usar PHI, es decir, información de salud protegida cubierta por HIPAA, en AI Hub. «Por ejemplo, nos preguntamos si podemos aprovechar esta herramienta para escribir cartas de apelación de denegación copiando un extracto de un registro médico y haciendo que Al resuma el registro de la apelación», dijeron. «Consideramos que esto se está desarrollando con otras organizaciones, así que por ahora simplemente hagamos una lluvia de ideas».

Un asesor de estrategia empresarial de Northwell respondió: «Sí, es seguro ingresar PHI y PII [Personally Identifiable Information] en la herramienta, ya que no irá a ninguna parte fuera de los muros de Northwell. ¡Es por eso que lo desarrollamos en primer lugar! Siéntase libre de usar para reanudar EMR [Electronic Medical Record] extractos y otra información. Como siempre, esté atento a cualquier dato que ingrese en cualquier lugar fuera de las herramientas aprobadas por Northwell”.

AI Hub se lanzó a principios de marzo de 2024, dijeron los presentadores, y desde entonces su uso se ha extendido principalmente de boca en boca dentro de la empresa. En agosto, más de 3.000 empleados de Northwell estaban usando AI Hub, dijeron, y antes de la demostración estaba ganando entre 500 y 1.000 nuevos usuarios por mes.

💡

¿Sabe algo sobre cómo su empleador está integrando la IA en su lugar de trabajo? Me encantaría saber de usted. un dispositivo que no sea de trabajo, puedes enviarme mensajes usando de forma segura en Signal al sam.404. De lo contrario, envíeme un correo electrónico a sam@404media.co.

Durante la presentación, obtenida por 404 Media y dada a más de 40 empleados de Northwell, incluidos médicos, científicos e ingenieros, Kaul y el ingeniero demostraron cómo funciona AI Hub y explicaron por qué se desarrolló. Al presentar la herramienta, Kaul dijo que Northwell vio ejemplos en los que sistemas de chat externos filtraban información confidencial o corporativa, y que las corporaciones prohibían el uso de «los ChatGPT del mundo» por parte de los empleados.

«Y cuando empezamos a discutir esto, comenzamos a decir, bueno, no podemos cerrar. [the use of ChatGPT] caeremos si no damos a la gente algo que usar, porque se trata de una tecnología apasionante y queremos aprovecharla al máximo”, dijo Kaul en la presentación. “Desde mi punto de vista, se trata menos de ser cerrados y reemplazados, sino más bien de cómo podemos aprovechar las capacidades que tenemos”.

A lo largo de la presentación, los presentadores sugirieron que los empleados de Northwell usaran AI Hub para cosas como preguntas sobre políticas hospitalarias y redacción de descripciones de trabajo o edición de escritos. En un momento dijo que «la gente ha estado usando esto para resúmenes de historias clínicas». Reconoció que los LLM a menudo se equivocan. “Eso, como sabe esta comunidad, es algo así como lo que ocurre con la IA de generación. No se puede sacarlo al pie de la letra, sea lo que sea”, dijo Kaul. “Siempre hay que seguir leyéndolo y revisando cualquiera de los resultados, y hay que seguir repitiéndolo hasta obtener el tipo de calidad de resultado que se busca si se desea utilizarlo para un propósito muy específico. Y por eso siempre seguiremos reforzando, tómalo como un borrador, revísalo y tú eres responsable de lo que uses”.

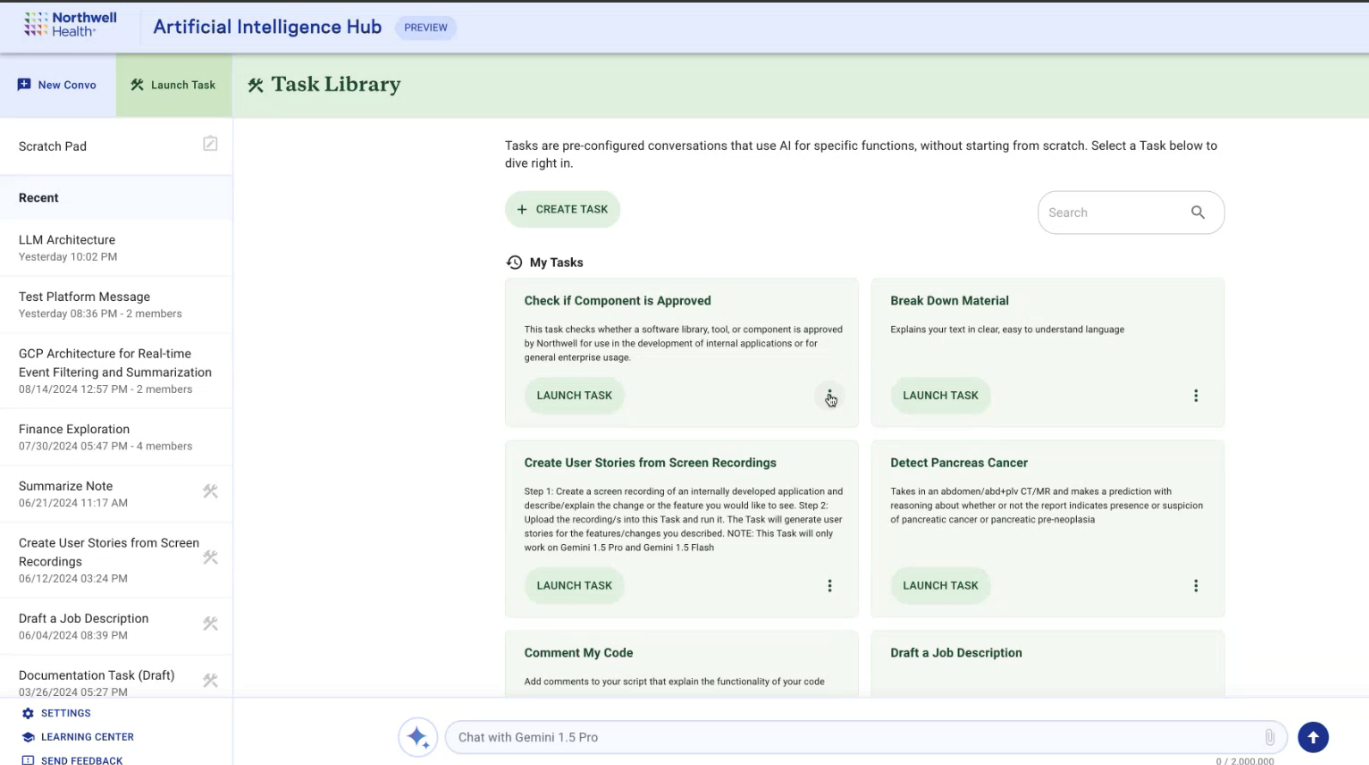

La herramienta se parece a cualquier interfaz LLM basada en texto: un cuadro de texto en la parte inferior para las entradas del usuario, las respuestas del chatbot en una ventana encima y una barra lateral que muestra las conversaciones recientes de los usuarios a la izquierda. Los usuarios pueden optar por iniciar una conversación o «iniciar una tarea». Los ejemplos de tareas que los presentadores dieron en su demostración de agosto incluyen tareas administrativas, como resumir materiales de investigación, pero también detectar cáncer y «analizar HL7», que significa Nivel de Salud 7, un estándar internacional de datos sanitarios que permite a los hospitales compartir registros y datos de salud de los pacientes entre sí de forma segura e interoperable.

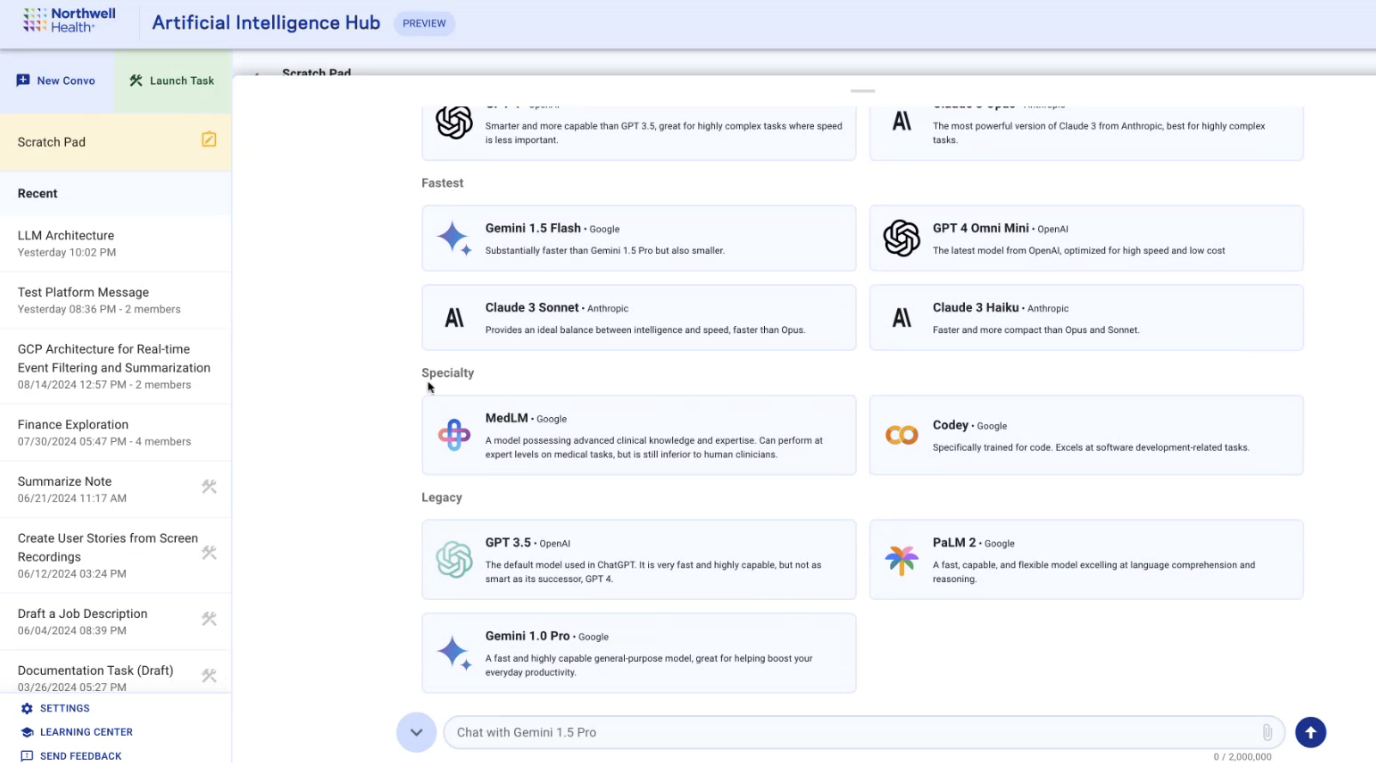

También pueden elegir entre uno de los 14 modelos diferentes para interactuar, incluidos Gemini 1.5 Pro, Gemini 1.5 Flash, Claude 3.5 Sonnet, GPT 4 Omni, GPT 4, GPT 4 Omni Mini, Codey, Claude 3 Opus, Claude 3 Sonnet, Claude. 3 Haiku, GPT 3.5, PaLM 2, Gemini 1.0 Pro y MedLM,

MedLM es un LLM desarrollado por Google y diseñado para la atención médica. Un cuadro de información para MedLM en AI Hub lo llama “un modelo que posee conocimientos y experiencia clínicas avanzadas. Puede desempeñarse a niveles expertos en tareas médicas, pero sigue siendo inferior a los médicos humanos”.

Las tareas son indicaciones guardadas y los ejemplos que los presentadores dan en la demostración incluyen «Desglosar material» y «Comentar mi código», pero también incluye «Detectar cáncer de páncreas», con la descripción «Toma una TC de abdomen/adb+plv / RM y hace una predicción con razonamiento sobre si el informe indica o no presencia o sospecha de cáncer de páncreas o preneoplasia de páncreas”.

Al principio, las tareas son privadas para los usuarios individuales, pero se pueden compartir con toda la fuerza laboral de Northwell. Los usuarios pueden enviar una tarea para que la revise «el equipo de AI Hub», según el texto de la demostración. En el momento de la demostración, los cargados directamente a una conversación o tarea caducaban en 72 horas. «Sin embargo, una vez que hagamos de esto una característica de las tareas, donde puedes guardar una tarea con un documento, hacerlo permanentemente, será un documento cargado permanentemente, podrás volver a esa tarea cuando quieras, y el documento seguirá ahí para que lo utilizas”, dijo el ingeniero mayor.

AI Hub también acepta cargas de fotos, audio, videos y archivos como PDF en Gemini 1.5 Pro y Flash, que es una característica que ha sido «muy solicitada» y que se está «utilizando mucho», dijeron los presentadores. Para demostrar esa característica, subió un PDF de 58 páginas sobre cómo monitorear a los pacientes de forma remota y le preguntó a Gemini 1.5 Pro «¿cuáles son los aspectos de facturación?» que el modelo resumen del documento.

Otro de los usos que Northwell sugiere para AI Hub es la contratación. En la demostración, el ingeniero subió dos currículums y le pidió al modelo que los comparara. Los lugares de trabajo utilizan cada vez más la IA en las prácticas de contratación, a pesar de las advertencias de que puede empeorar la discriminación y el sesgo sistémico. El año pasado, el La Unión Estadounidense de Libertades Civiles escribió que el uso de IA plantea “un enorme peligro de exacerbar la discriminación existente en el lugar de trabajo basado en raza, sexo, discapacidad y otras características protegidas, a pesar de las afirmaciones de marketing de que son objetivas y menos discriminatorias.

En un momento de la demostración, un radiólogo hizo una pregunta: «¿Existe algún tipo de supervisión médica o ética en la publicación de las tareas?» Imaginaron un escenario en el que alguien elige una tarea, dijeron, pensando que hace una cosa pero sin darse cuenta de que está destinada a hacer otra, y recibiendo resultados inexactos del modelo. “Vi uno que decía ‘detectar cáncer de páncreas en un informe de radiología’. Me doy cuenta de que esto podría ser un juego en este momento, pero en algún momento la gente comenzará a confiar en esto para tomar decisiones médicas”.

El ingeniero respondió que es por eso que las tareas requieren un período de revisión antes de ser publicadas en el resto de la red. “Ese proceso de revisión aún se está desarrollando… Especialmente para cualquier tarea que vaya a ser clínica o clínica adyacente, contaremos con aportes clínicos para asegurarnos de que estén listas y que, ya sabes, [they are] lo más inobjetable posible antes de que los implementemos para que estén disponibles para todos. Definitivamente entendemos que no queremos simples te permitir que la gente publique cualquier cosa para la comunidad en general”.

De acuerdo a un informe de Enfermeras Unidas Nacionales que encuestó a 2.300 enfermeras registradas y miembros de NNU de enero a marzo de 2024, el 40 por ciento de los encuestados dijo que sus empleadores “ha introducido nuevos dispositivos, aparatos y cambios en los registros médicos electrónicos (EHR) durante el año pasado” . Como ocurre con casi todas las industrias del mundo, hay una carrera para adoptar la IA en los hospitales, y los inversores y accionistas prometen una revolución en la atención médica si solo las redes adoptan la IA. «Estamos en un punto de inflexión en la IA donde podemos ver su potencial para transformar la salud a escala planetaria», afirmó Karen DeSalvo, directora de salud de Google Health. en un evento a principios de este año para el lanzamiento de las capacidades de radiografía de tórax de MedLM y otras actualizaciones. «Parece claro que en el futuro la IA no sustituirá a los médicos, pero los médicos que la utilizarán sustituirán a los que no la utilizan». algunos estudios mostrar resultados prometedores en la detección del cáncer utilizando modelos de IA, incluso cuando se utilizan para sorber complementar las evaluaciones de los radiólogos de las mamografías en los exámenes de detección del cáncer de mama, y Detección temprana del cáncer de páncreas..

«Todo el mundo teme que esto libere algo de tiempo para los médicos y luego, en lugar de mejorar la atención, se espera que hagan más cosas, y eso realmente no ayudará».

Pero los pacientes aún no lo creen. A Informe 2023 de Pew Research encontraron que el 54 por ciento de los hombres y el 66 por ciento de las mujeres dijeron que se sentían incómodos con el uso de la IA «en su propia atención médica para hacer cosas como diagnosticar enfermedades y recomendar tratamientos».

Un empleado de Northwell con el que habló sobre AI Hub me dijo que, como paciente, querría saber si sus médicos estaban utilizando IA para informar su atención. «Dado que los chats son monitoreados, si un médico carga un gráfico y obtiene un resumen, el equipo que monitorea el chat probablemente podría leer ese resumen, incluso si no pueden leer el gráfico», dijeron. (Northwell no respondió a una pregunta sobre quién puede ver qué información en las tareas).

“Esto es nuevo. Todavía estamos tratando de generar confianza”, me dijo en una llamada Vardit Ravitsky, profesor de bioética en la Universidad de Montreal, profesor titular de la Facultad de Medicina de Harvard y presidente del Centro Hastings. “Todo es experimental. Por esas razones, es muy posible que los pacientes deban saber más y no menos. Y nuevamente, es una cuestión de generar confianza en estos sistemas y ser respetuosos con la autonomía y el derecho de los pacientes a saber”.

El agotamiento de los trabajadores de la salud (aparentemente la razón detrás de la automatización de tareas como la contratación, la investigación, la redacción y la admisión de pacientes, como lo explicado el equipo de AI Hub en su demostración de agosto) es un problema real y apremiante. Según estimaciones del sectorel agotamiento podría costar a los sistemas de salud al menos 4.600 millones de dólares al año. Y si bien los informes de agotamiento disminuyeron en general en 2023 en comparación con años anteriores (durante los cuales ocurrió una pandemia global y el agotamiento alcanzó su punto más alto), más del 48 por ciento de los médicos “informaron haber experimentado al menos un síntoma de agotación”. según la Asociación Médica Estadounidense (AMA).

“¿Una fuente de ese estrés? Más de una cuarta parte de los encuestados dijeron que no tenían suficientes médicos y personal de apoyo. Había una necesidad constante de más enfermeras, asistentes médicos o asistencia con la documentación para reducir la carga de trabajo de los médicos”. un informe de la AMA basado en una encuesta nacional de 12,400 respuestas de médicos en 31 estados en 81 sistemas y organizaciones de salud, dijo. “Además, el 12,7% de los encuestados afirmó que demasiadas tareas administrativas eran la causa del estrés laboral. La falta de personal de apoyo, tiempo y pago por el trabajo administrativo también aumenta el estrés laboral de los médicos”.

La IA podría ser prometedora para abordar las cargas administrativas de los médicos. Un reciente (aunque pequeño y breve) estudiar descubrió que usar LLM para realizar tareas como redactar correos electrónicos podría ayudar con el agotamiento. Los estudios muestran que los médicos dedican entre el 34 y el 55 por ciento de sus días laborales a “crear notas y revisar registros médicos en el registro médico electrónico (EHR), tiempo que se desvía de las interacciones directas con los pacientes”, y que el trabajo administrativo incluye cosas como la documentación de facturación y el cumplimiento normativo. .

«La necesidad es muy urgente», dijo Ravitsky. “El agotamiento de los médicos debido a la toma de notas y la actualización de registros es un fenómeno real, y la esperanza es que el tiempo ahorrado se dedique al encuentro clínico real, mirando a los ojos del paciente en lugar de una pantalla, interactuando con ellos, obteniendo más información. información contextual de ellos, y realmente mejorarían la atención clínica”. Pero esto es un arma de doble filo: «Todo el mundo teme que esto libere algo de tiempo para los médicos y luego, en lugar de mejorar la atención, se espera que hagan más cosas, y eso realmente no ayudará», dijo. .

También está la cuestión de los riesgos de ciberseguridad asociados con la colocación de datos de pacientes en una red, incluso si se trata de un sistema cerrado.

«Me sentiría incómodo si los proveedores médicos utilizaran esta tecnología sin comprender las limitaciones y los riesgos»

Blake Murdoch, investigador asociado principal del Health Law Institute de Alberta, me dijo en un correo electrónico que si se trata de una herramienta interna que no envía datos fuera de la red, no es necesariamente diferente de otros tipos de software de intranet. «Sin embargo, la forma en que se utilice sería importante», afirmó.

“En general, tenemos el principio de privilegio mínimo para la PHI en particular, según el cual debe haber una necesidad operativa para justificar el acceso al expediente de un paciente. Es necesario minimizar los niveles innecesarios de vigilancia”, afirmó Murdoch. “La ley de privacidad puede redactarse de manera amplia, de modo que el monitoreo que usted menciona no constituye automáticamente una violación de la ley, pero podría decirse que podría violar los principios subyacentes y ser cuestionado. Además, parte de esto podría resolverse mediante la desidentificación automatizada de la información del paciente utilizada en los LLM, como eliminar nombres y asignar números, etc., de modo que quienes monitorean no puedan rastrear las acciones en el LLM hasta pacientes identificables”.

Como señaló Kaul en la demostración de AI Hub, las corporaciones de hecho están prohibiendo el uso de «los ChatGPT del mundo». El año pasado, un El usuario de ChatGPT dijo su cuenta filtra contraseñas e historiales de chat de otras personas. Múltiples agencias federales han bloqueado el uso de servicios de IA generativa en sus redes, incluido el Departamento de Asuntos de Veteranos, el Departamento de Energía, la Administración de la Seguridad Social y el Departamento de Agricultura, y la Agencia para el Desarrollo Internacional. empleados publicitarios no introducir datos privados en sistemas públicos de IA.

Casey Fiesler, profesor asociado de Ciencias de la Información en la Universidad de Colorado Boulder, me dijo en una llamada que si bien es bueno que se disuada a los médicos de ingresar datos de pacientes en la versión web abierta de ChatGPT, es importante cómo la La red de Northwell implementa salvaguardas de privacidad. —al igual que la educación para los usuarios. “Espero que si se anima al personal del hospital a utilizar estas herramientas, haya alguna significativo educación sobre cómo funcionan y cómo es apropiado y no apropiado”, dijo. “Me sentiría incómodo si los proveedores médicos utilizaran esta tecnología sin comprender las limitaciones y los riesgos. »

ha habido varios ataques de ransomware en hospitales recientemente, incluido el Cambiar la violación de datos de atención médica a principios de este año que expuso la información de salud protegida de al menos 100 millones de personas, y un Ataque de ransomware del 8 de mayo contra la Ascensión, un sistema de salud católica compuesto por 140 hospitales en más de una docena de estados, cuyo hospital personal estaba Todavía recuperándome de semanas después..

Sarah Myers West, codirectora ejecutiva del AI Now Institute, dijo a 404 Media que los profesionales de la salud como National Nurses United han estado dando la alarma sobre la IA en entornos de atención médica. «Un conjunto de preocupaciones que han planteado es que, con frecuencia, la implementación de estos sistemas es un pretexto para reducir la dotación de personal que atiende a los pacientes, y eso conduce a daños reales», dijo, señalando un informe de Bloomberg de junio Dicho esto, una herramienta de inteligencia artificial de Google destinada a analizar los registros médicos de los pacientes no detectó las alergias a los medicamentos del paciente. Una enfermera se dio cuenta de la omisión. West dijo que, además de las preocupaciones sobre privacidad y seguridad, este tipo de fallas en los sistemas de inteligencia artificial tienen consecuencias de “vida o muerte” para los pacientes.

A principios de este año, un grupo de investigadores descubrió que la herramienta de transcripción Whisper de OpenAI inventó oraciones, informó Associated Press. Los investigadores—que presentó su trabajo como un documento de conferencia en la Conferencia ACM de 2024 sobre Justicia, Responsabilidad y Transparencia en junio, escribió que muchas de las transcripciones de Whisper eran muy precisas, pero aproximadamente el uno por ciento de las transcripciones de audio “contenían frases u oraciones enteras alucinadas que no existían de ninguna forma en el audio subyacente”. .” Los investigadores analizaron el contenido alucinado de Whisper y descubrieron que el 38 por ciento de esas alucinaciones «incluyen daños explícitos como perpetuar la violencia, inventar asociaciones inexactas o implicar una autoridad falsa». ellos escribieron. Nabla, una herramienta copiloto de IA que comercializa recientemente recaudó $24 millones En una ronda de financiación de la serie B, utiliza una combinación de la API de conversión de voz a texto disponible en el mercado de Microsoft y el modelo Whisper perfeccionado. Nabla ya se utiliza en los principales sistemas hospitalarios incluyendo la Universidad de Iowa.

«Hay muchos ejemplos de este tipo de errores o fallas que se ven agravados por el uso de sistemas de inteligencia artificial para reducir la dotación de personal, donde de otro modo este sistema hospitalario podría dotar adecuadamente a las camas de sus pacientes y conducir a mejores resultados clínicos”, dijo West.